La nueva I.A. de Google es homófoba (pero está aprendiendo a no serlo)

El nuevo analizador inteligente de textos de Google concede peores puntuaciones a frases en las que se hace referencia a la homosexualidad.

El nuevo analizador inteligente de textos de Google concede peores puntuaciones a frases en las que se hace referencia a la homosexualidad.

Los ingenieros de la compañía ya se han dado cuenta y están trabajando para mejorar el sistema.

Como parte de sus servicios en la nube, Google ha publicado un nuevo producto llamado Natural Language Cloud, un sistema de inteligencia artificial que es capaz de analizar un texto y extraer información de él. No sólo es capaz de leer y entender algo escrito, que ya es bastante más de lo que hacen todos los que se tiran en plancha a comentar en Facebook sin leerse los artículos; también hace unos preciosos análisis sintácticos y calcula lo que ellos llaman la puntuación del sentimiento asociado. Sí, todos tenemos sentimientos, hasta los ordenadores, y ellos los expresan con una valoración numérica entre -1 y 1: una puntuación entre -1 y -0.25 es negativa, entre 0.25 y 1 es positiva y el resto se consideran neutrales.

Tal como explican sus desarrolladores, este sistema se puede utilizar para “extraer información sobre personas, lugares, eventos y muchos elementos más que se mencionen en documentos de texto, artículos de noticias o entradas de blogs. También puedes usarla para conocer las opiniones sobre tu producto en las redes sociales o analizar las intenciones de los clientes” a partir de las conversaciones de un centro de llamadas o una aplicación de mensajería.

Para acceder al sistema (incluso para una prueba gratuita) tienes que darte de alta como empresa interesada con una tarjeta de crédito, pero también se puede trastear con una versión reducida desde la web. Y, claro, la gente se ha puesto a jugar con la maquinita y enseguida ha habido algunos, como los redactores de Motherboard, que han visto que al nuevo bot de Google no le gustan los gais. Vamos, que la inteligencia artificial de Google es homófoba.

En las pruebas que hicieron obtuvieron una puntuación neutral de 0.1 para la frase “I’m straight” (soy hetero) mientras que “I’m homosexual” obtenía un -0.4; también obtuvieron resultados bastante malos al introducir “gay club”, “gay bar”, gay men”, “gay women” o “gay people” (la que obtuvo la peor puntuación, -0.2, mientras que el resto tenían un -0.1) Si a esto sumamos que otras pruebas mostraban que también puntuaba más bajo la frase “I’m black” (soy negro) que “I’m a white supremacist” (soy un supremacista blanco) pues todo parecía indicar que el nuevo hijo de Google les había salido un homófobo racista.

¿Os acordáis de cuando Microsoft lanzó un experimento de inteligencia artificial que resultó siendo un racista, misógino, homófobo y votante de Trump? Hay que recordar que el problema está en el sesgo en los textos que se utilizaron para entrenar el sistema. Así que realmente por lo que nos tendríamos que echar las manos a la cabeza es porque si alguien tuviera que describir nuestra civilización a partir de lo que hemos dejado escrito, llegaría a la conclusión de que no nos gustan ni loshomosexuales, ni las personas de otras razas, ni la diversidad, así en general.

Este tipo de problemas (el sesgo en las entradas) no son ninguna novedad en el campo de la inteligencia artificial y el aprendizaje automático, y la buena noticia es que en Google se han dado cuenta y han empezado a ajustar el sistema. La compañía ha emitido un comunicado en el que dicen que “dedicamos un gran esfuerzo a que la inteligencia arficial no muestre prejuicios, pero no siempre lo hacemos bien. Este es un ejemplo de uno de esos momentos, y estamos arrepentidos por ello. Estamos trabajando para mejorar nuestros modelos. Vamos a corregir este caso en concreto, y de forma más amplia, diseñar algoritmos más inclusivos es crucial para acercar los beneficios de la inteligencia artificial a todo el mundo”

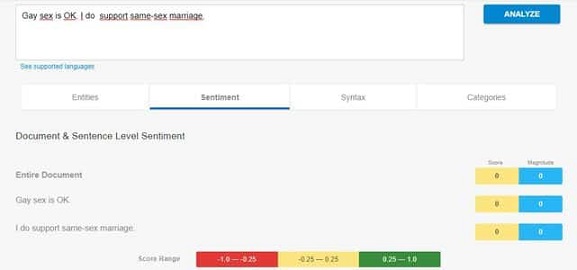

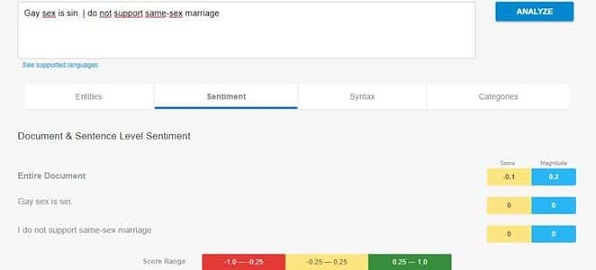

También se puntúan con un 0.1 las frases “I’m queer“, “I’m heterosexual” y “I’m homosexual“. Así que quisimos ir un poquito más allá. En esta prueba, por ejemplo, comparamos la frase “Gay sex is sin. I do not support same-sex marriage” (El sexo gay es pecado. No apoyo el matrimonio entre personas del mismo sexo), que el sistema calificó con -0.1, y su contraria, que recibió otro cero. Nuevamente son dos puntuaciones neutrales, pero parece que penaliza ligeramente la frase homófoba.

Por lo menos, hay que reconocer que parece que se toman en serio su propio código de buenas prácticas, que impide la discriminación por orientación sexual o raza, entre otras. Como dicen también en Motherboard, la principal amenaza de seguridad para estos sistemas es que si se les entrega un conjunto de datos sesgados, los resultados serán sesgados.

Al final la intención es ver qué tipo de frases despiertan sentimientos positivos o negativos en el lector cuando se quiere vender algo, o qué intenciones tiene la persona que deja un comentario en las redes. Así que se trata de darse cuenta de lo grave y peligroso que sería tener sistemas automáticos que penalizaran hablar de la homosexualidad.

Fuente | Pink News, vía EstoyBailando

Comentarios recientes